بسیاری از افراد پس از سکته یا به علت بیماری قادر به صحبت کردن نیستند. سیگنالهای مغزی آنچه این افراد قصد دارند بگویند را در خود مخفی کرده است. هیچکس تاکنون قادر به رمزگشایی این سیگنالها نبوده است. اما سه گروه پژوهشی به تازگی پیشرفتهایی در تبدیل سیگنالهای مغزی به سخن داشتهاند. این سیگنالها توسط الکترودهایی که به صورت تهاجمی روی مغز قرار گرفتهاند دریافت میشود. با استفاده از مدلهای محاسباتی که به عنوان شبکههای عصبی شناخته میشوند، کلمات و جملات بازسازی میشود. برخی از این جملات بازسازی شده توسط رایانه برای شنوندگان قابل فهم است. با مجله فناوریهای توانافزا و پوشیدنی همراه باشید.

در هیچ یک از تلاشهای اخیر، پژوهشگران به بازسازی جملات و تشخیص سخن نپرداختند. آنها به ثبت سیگنالهای مغزی از بخشهای مختلف مغز میپرداختند. بخشهایی که مربوط به خواندن با صدای بلند، صحبت کردن در سکوت و یا گوش دادن است. استفانی مارتین (Stephanie Martin)، مهندس عصبی در دانشگاه ژنو سوئیس، که در پروژههای جدید دخیل نبود، نشان داده است که سخنان بازسازی شده قابل فهم است.

افرادی که توانایی صحبت کردن را پس از سکته یا به علت بیماری از دست دادهاند میتوانند از چشمان خود یا حرکات کوچک دیگری برای کنترل مکاننما یا انتخاب بر روی صفحه نمایش استفاده کنند. اما اگر یک رابط مغز و رایانه بتواند مستقیماً سخنان را بازسازی کند، مزایای بیشتری دارد: برای نمونه کنترل تن صدا یا توانایی یک مکالمه سریع.

موانع بسیاری وجود دارد

نیما مسگرانی، دانشمند رایانه در دانشگاه کلمبیا میگوید: «ما تلاش میکنیم الگوی نورونها را درک کنیم تا به سخنان پی ببریم». چگونگی تبدیل این سیگنالها به گفتار در افراد متفاوت است. بنابراین مدلهای رایانهای باید برای هر فرد آموزش داده شود. مدلها باید با دادههای بسیار دقیق، که نیازمند باز کردن جمجمه است، بهینه شوند.

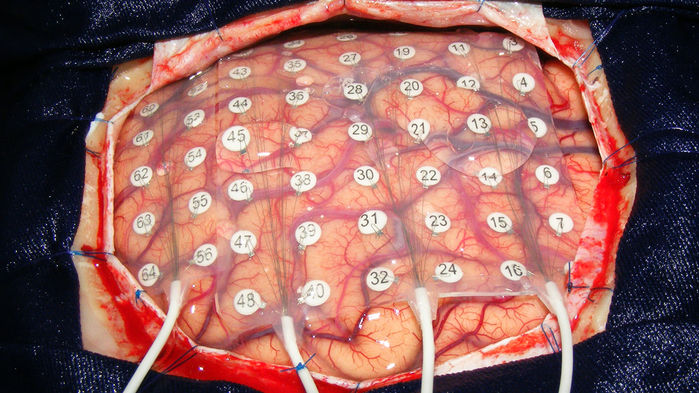

پژوهشگران چنین ثبت تهاجمی را در موارد نادری انجام میدهند. یکی از این موارد در هنگام برداشتن تومور مغزی است. زمانی که خواندن سیگنالهای الکتریکی از مغز به جراحان در مکانیابی و اجتناب از نواحی کلیدی حرکتی و گفتاری کمک میکند. دیگری مواردی است که پیش از جراحی یک فرد مبتلا به صرع برای چندین روز از الکترودها برای تشخیص منشأ تشنج استفاده میشود. مارتین میگوید: «ما حدأکثر ۲۰ تا ۳۰ دقیقه برای جمعآوری دادهها زمان داریم که واقعاً محدود است».

بازسازی اعداد شنیده شده بر اساس فعالیت مغز

گروه مسگرانی بر دادههای گرفته شده از پنج نفر مبتلا به صرع متکی بود. برای این بیماران داستانهای ضبط شدهای پخش شد. سپس رایانه دادههای ثبت شده از قشر شنوایی (که در طول صحبت کردن و گوش دادن فعال است) را تجزیه و تحلیل کرد. برای آزمایش این مدل، اعداد یک تا نه را برای این افراد خواندند. رایانه اعداد شنیده شده را تنها بر اساس دادههای عصبی بازسازی کرد. اعدادی که رایانه نام برد با دقت ۷۵ درصد برای شنوندگان قابل فهم بود.

بازسازی رایانهای اعدادی که بیماران شنیدند، تنها بر اساس فعالیت مغزی H. AKBARI ET AL., DOI.ORG/10.1101/350124

بازسازی کلمات بیان شده بر اساس فعالیت مغز

گروه دیگری که توسط دانشمند رایانه Tanja Schultz در دانشگاه برمن آلمان رهبری میشود، بر دادههای شش نفر که تحت عمل جراحی تومور مغزی قرار گرفتهاند تمرکز دارد. یک میکروفون صدای آنها را زمانی که کلمات تک هجا را میخوانند ضبط میکند. در همین حال، الکترودها سیگنالهای الکتریکی ناحیه گفتاری مغز و مناطق حرکتی که دستورات را به دستگاه صوتی برای بیان کلمات میفرستند را ضبط میکند. دانشمندان رایانه Miguel Angrick و Christian Herff، در دانشگاه Maastricht، شبکهای را آموزش دادهاند تا کلمات را از دادههای مغزی بازسازی میکند. طبق یک سامانه امتیاز دهی، حدود ۴۰ درصد از کلمات بازسازی شده قابل فهم بود.

صدای اصلی یک شرکت کننده در پژوهش و به دنبال آن بازسازی رایانهای هر کلمه بر اساس فعالیت ناحیه گفتاری و حرکتی مغز M. ANGRICK ET AL., DOI.ORG/10.1101/478644

در نهایت، ادوارد چانگ (Edward Chang) جراح اعصاب و گروه وی در دانشگاه کالیفرنیا سانفرانسیسکو، جملات کامل را با توجه به فعالیت مغزی مناطق گفتاری و حرکتی، بازسازی کرد. در اینجا سه بیمار مبتلا به بیماری صرع، با صدای بلند جملات را میخواندند. در یک آزمایش آنلاین، ۱۶۶ نفر یک جمله را شنیدند و آن را از میان ۱۰ گزینه نوشته شده انتخاب کردند. جملات با دقت بیش از ۸۰ درصد به درستی شناسایی شدند. پژوهشگران از این مدل برای بازسازی کلماتی که افراد به آرامی لب میزدند، استفاده کردند. Herff میگوید: «یک قدم به پروتزهای گفتاری که همه ما در ذهن داریم نزدیک شدیم».

با این حال، Stephanie Riès، یک دانشمند علوم اعصاب در دانشگاه ایالتی سندیگو در کالیفرنیا که در زمینه گفتار پژوهش میکند، میگوید: «آنچه ما واقعاً انتظار داریم این است که این روشها زمانی که بیماران قادر به صحبت نیستند، کار کند». سیگنالهایی مغزی زمانی که یک فرد صحبت میکند یا میشنود با سیگنالهای گفتاری یا شنوایی یکسان نیست. بدون صدای خارجی برای انطباق با فعالیت مغز، آموزش شبکهها دشوار است. بنابر گفته Herff ممکن است دادن بازخورد به کاربر از رابط کاربری مغز و رایانه گره گشا باشد. اگر کاربر بتواند صدای رایانه را بشنود میتواند افکار خود را برای رسیدن به نتیجه مورد نظر تنظیم کند.

بیشتر بخوانیم:

>>کاهش قابل توجه خطای سامانه تشخیص گفتار شرکت گوگل

>>بیماران تتراپلژی به کمک رابط مغز و رایانه توانستند یک تبلت را کنترل کنند

>>پنج چشم انداز کاربرد فناوری های رابط مغزی در آینده

منبع: sciencemag

«استفاده و بازنشر مطالب تنها با ذکر لینک منبع و نام (مجله فناوریهای توانافزا و پوشیدنی) مجاز است»